科技推荐:Nvidia满足了对自然语言处理的需求

科技改变生活,也在一定的程度上科改善生活!那么现如今生活条件越来越好以后大家更多的关注点都不同,但是近来有很大一部分了却同时关注到了Nvidia满足了对自然语言处理的需求的消息!

随着对聊天机器人和人工智能交互的自然语言处理需求的增长,越来越多的公司需要能够提供它的系统。Nvidia表示其平台可以处理它。Nvidia在对话自然语言处理(NLP)培训和推理方面拥有突破,可以在客户和聊天机器人之间实现更复杂的交换,并立即做出响应。

Juniper Research的数据显示,预计这种技术的需求将增长,因为预计未来四年内仅数字语音助理将从25亿增加到80亿,而Gartner预测,到2021年,所有客户服务互动的比例将达到15%。 AI将完全处理,比2017年增加400%。该公司表示其DGX-2 AI平台在不到一个小时的时间内培训了BERT-Large AI语言模型,并在2+毫秒内完成了AI推理,使得开辟人员可以使用最先进的语言理解 - 规模应用。“

变形金刚的BERT或双向编码器表示是一种基于Google的AI语言模型,许多开辟人员认为在一些性能评估中,它比人类具有更高的准确性。这一切都在这里讨论。

Nvidia设置自然语言处理记录

总而言之,Nvidia声称拥有三张NLP记录:

1.培训:运行最大版本的BERT语言模型,Nvidia DGX SuperPOD配备92个运行1,472 V100 GPU的Nvidia DGX-2H系统,可将培训时间从几天缩短到53分钟。单个DGX-2系统的大小与塔式PC相当,在2.8天内训练了BERT-Large。

应用深度学习研究副总裁Bryan Catanzaro在一份声明中说:“我们可以越快地训练模型,我们可以训练的模型越多,我们对问题的了解就越多,结果就越好。”

2.推论:在其TensorRT深度学习推理平台上使用Nvidia T4 GPU,Nvidia在2.2毫秒内对BERT-Base SQuAD数据集进行了判断,远低于许多实时应用的10毫秒处理阈值,远远领先于40使用高度优化的CPU代码测量的毫秒数。

3.型号:Nvidia表示其新的定制模型,称为Megatron,拥有83亿个参数,比BERT-Large大24倍,是世界上最大的基于变形金刚的语言模型,变形金刚是用于BERT和其他自然语言AI的构建模块楷模。

为了让FOSS的拥护者感到高兴,Nvidia也通过GitHub提供了大量的源代码。

使用PyTorch的NVIDIA GitHub BERT培训代码

TensorFlow的NGC模型脚本和检查点

TensorRT在GitHub上优化了BERT样本

更快的Transformer:C ++ API,TensorRT插件和TensorFlow OP

MXNet Gluon-NLP,支持AMP的BERT(培训和推理)

AI Hub上的TensorRT优化BERT Jupyter笔记本

Megatron-LM:用于训练大型变压器模型的PyTorch代码

并不是说这很容易消耗掉。我们正在谈论非常先进的AI代码。很少有人能够做出正面或反面。但这种姿态是积极的。

-

我省城乡建设一路风景一路歌

2021-08-12

-

住房和城乡建设部:严控城市更新中急功近利大拆大建

2021-08-12

-

数百名中美洲移民遭美国驱逐落脚危地马拉

2021-08-12

-

什么比特币观察者在过去10,000美元的浪涌之后说

2021-08-12

-

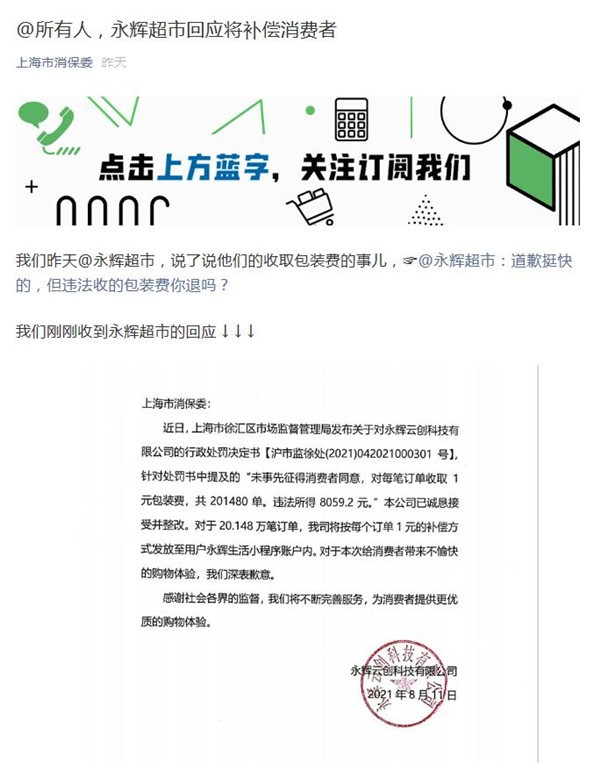

安徽丰原集团旗下泰格生物涉污被查

2021-08-12

-

Infosys,TCS,Wipro,Dish TV,Copustoday雀巢的股票

2021-08-12

-

洋葱价格在亚洲集会作为印度克制Xports

2021-08-12

-

RBI以6%保持不变的回购速度:检查Sensex如何在2018财年对RBI政策作出反应

2021-08-12

-

离开巴萨非常艰难 但我很高兴来到这里

2021-08-12

- 1 [商业热点]科技推荐:重新设计的用户体验可在墨西哥消防电视台上使用Alexa

- 2 [商业热点]荣耀20S正面搭载6.26英寸LCD魅眼屏

- 3 [商业热点]Helio G90T专业游戏芯片运行超流畅

- 1 [品牌资讯]科技推荐:Nvidia满足了对自然语言处理的需求

- 2 [创业商讯]科技推荐:SegwayNinebot的新型电动滑板车可以自动驾驶充电器

- 3 [创业商讯]科技推荐:三星错误地过滤了GALAXYS20FE智能手机

- 4 [商业热点]科技推荐:重新设计的用户体验可在墨西哥消防电视台上使用Alexa

- 5 [品牌资讯]科技推荐:华为WATCHGT2PRO保时捷设计版智能手表照片泄露

- 6 [创业商讯]科技推荐:三星GalaxyNote10和Note10+无与伦比的10个理由

- 7 [创业商讯]荣耀在武汉正式发布荣耀最强自拍手机荣耀20S