为什么深度网络在与统计直觉相悖的情况下仍能泛化

入门统计课程教导我们,当将模型拟合到某些数据时,我们应该有更多的数据而不是自由参数,以避免过度拟合噪声数据的危险,从而无法拟合新的数据。 因此,令人惊讶的是,在现代深度学习中,实践是拥有比数据更多的数量级参数。 尽管如此,深度网络显示出良好的预测性能,事实上,它们拥有的参数越多越好。 为什么会这样?

一段时间以来,机器学习中良好的性能来自于控制网络的复杂性,这不仅仅是自由参数数量的简单函数。 分类器的复杂性,如神经网络,取决于测量该网络所代表的函数空间的“大小”,前面提出了多种技术措施:Vapnik-Chervonenkis维数,包括数字,或Rademacher复杂性。 用这些概念衡量的复杂性,可以通过对参数的规范施加限制来控制学习过程中的复杂性-简而言之,限制它们能得到多大的“大”。 令人惊讶的事实是,在训练深层网络时似乎不需要这样明确的约束。 深度学习是否在古典学习理论之外? 我们需要重新思考基础吗?

在一篇新的自然通讯论文“深度网络中梯度下降的复杂性控制”中,由麻省理工学院大脑和认知科学系尤金·麦克德莫特教授Tomaso Poggio主任领导的大脑、思维和机器中心的一个团队解决了现代深度学习最实际和最成功的应用:分类问题,从而揭示了这一难题。

对于分类问题,我们观察到,实际上模型的参数似乎没有收敛,而是在梯度下降过程中无限期地增长。 然而,在分类问题中,只有归一化参数重要-即它们定义的方向,而不是它们的大小,“合著者和麻省理工学院博士说。 D.候选人千里廖.. “我们所展示的不太明显的一点是,在未归一化参数上常用的梯度下降导致了对归一化参数的期望复杂度控制。”

Poggio说:“对于像内核机器这样的浅层线性网络,在回归的情况下,我们已经知道梯度下降的迭代提供了一种隐式的、消失的正则化效果。” 事实上,在这种简单的情况下,我们可能知道,我们得到了最好的最大边际、最小范数的解决方案。 我们问自己的问题是:深层次的网络会不会发生类似的事情?

研究人员发现它确实如此。 正如合著者和麻省理工学院博士后AndrzejBanburski所解释的那样,“理解深度网络中的收敛性表明,改进我们的算法有明确的方向。 事实上,我们已经看到了一些暗示,即控制这些未归一化参数发散的速率可以使我们找到性能更好的解决方案并更快地找到它们。”

这对机器学习意味着什么? 深层网络背后没有魔力。 所有线性模型背后的同样理论也在发挥作用。 这项工作提出了改进深层网络的方法,使它们更准确和更快地训练。

-

买这个rakesh jhunjhunwala库存与航空公司一起飞翔

2021-08-13

-

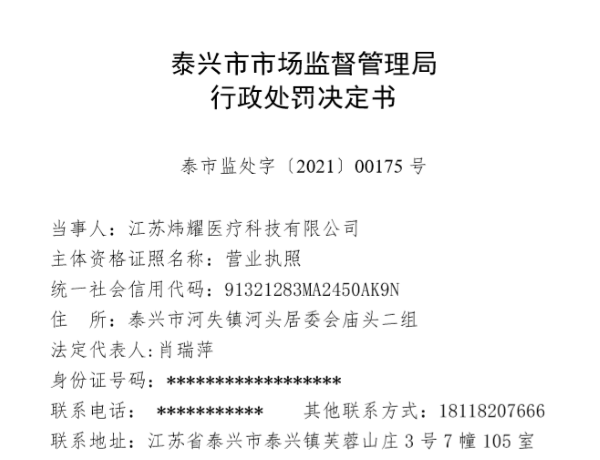

江苏炜耀医疗科技有限公司“无证生产医用防护口罩 、虚假标注生产日期” 被处罚款28万元

2021-08-13

-

你错过了这些IPO中的任何一个顶级共同资金射杀了inoctober吗?

2021-08-13

-

印度河大厦因增长担忧跌至逾8个月低点

2021-08-13

-

美光科技股票周四下跌

2021-08-13

-

美元萎缩2个月低与日元,美国税计划infocus

2021-08-13

-

【小康圆梦】高平:小小油葵撬动大产业带领群众走向致富路

2021-08-13

-

全球连线丨面具后的美国

2021-08-13

- 1 [商业热点]Infosys挑选Salil Parekh作为首席执行官和MD被尝试并测试了移动;过渡应该快速:JMFinancial.

- 2 [商业热点]监管机构在美国国债上看闪耀更多亮点

- 3 [商业热点]澳优2021年上半年营收42.71亿元 羊奶粉业务恢复加速

- 1 [时事评论]您的番茄迷信设置为钱包重量;这是为什么

- 2 [创业商讯]绿键交易达到历史新高达到了1000亿美元

- 3 [环球要闻]Maha Agri董事会将207英亩发展进出口发展

- 4 [股票基金]Rajesh出口股票,艾草电机,Sun Pharma,JP Associates,塔塔全球饮料,Cofustoday的依赖资本

- 5 [财经资讯]Airtel库存,HDFC标准人寿保险,Focustoday的喷气式飞机

- 6 [商业热点]Infosys挑选Salil Parekh作为首席执行官和MD被尝试并测试了移动;过渡应该快速:JMFinancial.

- 7 [经济报道]Reliance Industries在Usyield上的135个BPS价格为美元债券